基于专家示范深度强化学习的光伏系统MPPT控制

相关热词搜索:

王逸轩,戴宇轩

(上海电力大学自动化工程学院,上海 200090)

影响太阳电池阵发电功率的因素主要为温度与辐照度。为了提高经济性,电池阵需要在不同环境条件下尽可能输出最大功率。最大功率点跟踪(maximum power point tracking,MPPT)是利用适宜算法控制电子装置对太阳电池阵的端电压及输出电流进行实时调节,动态跟踪极值使其运行在最大功率点附近的功率控制技术。

国内外学者们提出过许多MPPT 控制算法。第一类是基于参数选择的间接控制法,其中常见的间接控制算法是开路电压法与短路电流法。这类算法的优点是简单易行,缺点是鲁棒性差,不能适应任何变化[1]。第二类算法是基于采集数据的直接控制法,常见的算法是扰动观察法(P&O)[2]、电导增量法(INC)等。这类算法复杂性低且面对环境稳定的情况效果较好,但它们在最大功率点附近会产生持续的震荡,面对环境条件变化的情况会缺乏鲁棒性从而降低运行效率。第三类算法是基于智能控制的算法,例如基于模糊逻辑规则的算法[3]、基于神经网络的控制算法[4]等。这类算法往往需要更多的先验知识作为信息,成为了近年来MPPT 控制算法研究的热门方向。

在第三类算法中,文献[5]提出了改进的粒子群MPPT 控制算法,它通过提升太阳电池阵输出功率的寻优速度和动态性能,能够更好地适应复杂外部环境。文献[6]使用改进麻雀搜索算法对MPPT 阵列进行建模和仿真,该算法快速准确地找到最大功率点,取得了良好的效果。

近年来,深度强化学习(deep reinforcement learning,DRL)技术被学者们应用于光伏系统的MPPT 控制算法中。为了获得高精度的输出电压并优化MPPT 动态效率,强化学习算法中的动作空间调整为连续动作空间[7]。文献[8]提出了一种DDPG 的强化学习算法用于将深度强化学习(DRL)离散域的动作空间扩展到连续域。然而文中的训练模型具有两处缺陷,其一是没有考虑复杂环境的变化,面对环境变化的鲁棒性较差;

其二是采用DDPG 算法直接训练MPPT 问题时收敛速度慢甚至无法收敛,导致训练时间过长。针对上述问题,本文采用了基于专家示范深度确定性策略梯度算法的MPPT控制算法,一方面提升MPPT 动态效率,另一方面加快了模型的收敛速度。

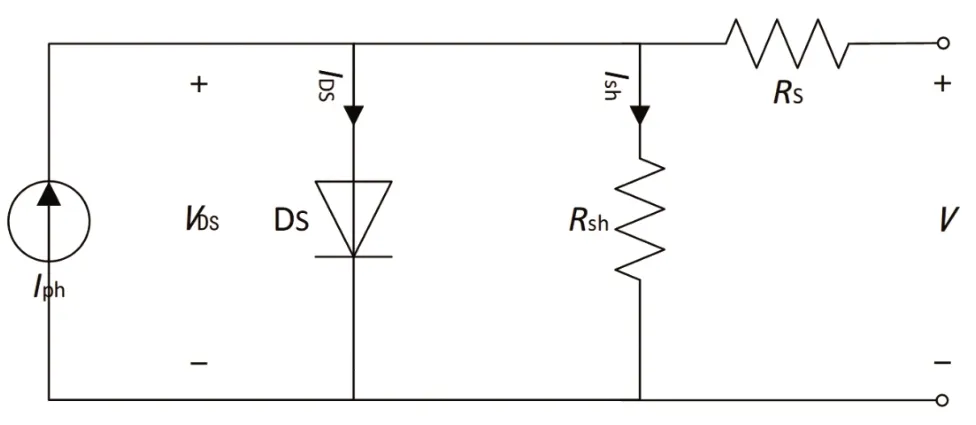

图1 是太阳电池的单二极管模型。Iph是电池照射太阳光后产生的电流,IDS是流过二极管的电流,VDS是二极管两端电压,Ish为通过分流并联电阻Rsh的电流,I为太阳电池的输出电流。当环境温度与光照强度不变时,太阳光产生的电流Iph保持不变,可以看作一个恒流源。

图1 太阳电池单二极管模型

太阳电池输出电流I的表达式为:

二极管电流IDS的表达式为:

式中:I0为二极管饱和电流;

q为单位电荷;

K为玻尔兹曼常数;

T为开氏温度;

η为二极管的理想因子,一般取值1~2,理想二极管因子为1。

光生电流Iph受到太阳辐照度G与环境温度T的影响,关系式见式(3)。

式中:Iscr为短路电流;

Ki为环境温度影响因子;

Tr为环境温度参考值。

二极管饱和电流I0见表达式(4)。

式中:IRS为二极管反向饱和电流;

Eg为二极管的带隙能量。

太阳电池阵通常由若干个太阳电池经过串并联后组成。假设一个太阳电池阵包含N个并联的太阳电池电路,每个电路由M个单体太阳电池串联构成,则太阳电池阵输出电流Ism见式(5)。

从式(5)可以看出,电池阵输出特性主要受到环境温度T、太阳辐照度G的影响。图2(a)~(d)分别展示了在恒定环境温度改变太阳辐照强度与恒定太阳辐照强度改变环境温度条件下的输出I-V与P-V特性曲线。

图2 温度、光照条件变化时光伏特性曲线

深度强化学习是在强化学习的基础上将具有强大表征能力的深度学习与具有决策能力的强化学习相结合,使动作序列空间与状态值空间映射为深度学习神经网络,以便处理高维度的动作与状态[9]。对于本文中研究的光伏系统MPPT问题,使用深度神经网络来表征光伏系统在不同状态下的价值函数,再结合强化学习算法根据价值函数决策出当前时刻的电压变化量。深度强化学习中的相关术语以及表达式如下[10]:

价值函数V为从该状态开始的马尔科夫决策过程获得的总期望:

状态动作值函数Qπ(s,a)表示在状态s下根据策略π 采取某个动作a时获得的收获的期望:

深度确定性策略梯度算法(DPPG)是以演员-批评家(actor-critic)为基础[11],针对连续动作空间的离线无模型算法。DDPG 算法共有四个网络,它们分别是演员网络、演员目标网络、批评家网络和批评家目标网络。状态动作值函数和动作函数分别由深度神经网络Q(st,at|θQ)和μ(st|θμ)训练得到,其中,θQ与θμ对应了批评家网络和演员网络中的各层各节点的权值与偏差矩阵。

批评家网络参数的更新通过最小化损失函数L(θQ)来实现,见式(8)。

式中:yt为预期回报;

rt为当前状态动作下的奖励;

γ为衰减率,一般取0.9~1。

演员网络的参数θμ可以通过梯度方法更新,见式(10)。

式中:?为偏导数;

J为演员网络参数关于回报期望的分布;

ρβ为状态st所服从的分布。

批评家目标网络与演员目标网络通过软更新方式改变参数。两个目标网络分别设置更新率τ,当一次训练结束时,目标网络向原始网络的参数更新τ%,保留(1-τ)%的网络参数不变。

考虑到控制的目标输出电压是一个连续变量,本文首先采用DDPG 算法来控制MPPT 过程,其次加入专家示范的方法来解决DDPG 算法中训练时间过长、收敛难度大的问题。

3.1 状态空间与状态扩张

DDPG 算法中的状态采用温度T、光照G、电压V、功率P四个不同的量[12],其中电压和功率包含最近连续的三个时刻(t,t-1,t-2)的值。状态矩阵S如下所示:

为了增加专家示范的适应性,需要对状态作出如下调整:

式中:I为电流值,I(t)=P(t)/V(t);

ΔP为功率变化值,ΔP(t)=P(t)-P(t-1)。

调整后的状态矩阵与之前相比增加了四个元素,主要用于提高算法中的网络对专家示范经验的适应性以及神经网络对特征的识别能力。同时,这四个元素是由电压与功率经过线性变换得出,一旦前八个状态量确定,后四个状态量也随之确定,因而本质上算法中的状态维度并未发生改变。

3.2 动作空间

光伏系统MPPT 控制中被控对象是输出电压,因此动作需要选取与电压有关的变量。本算法采用电压的变化量作为动作值,通过获取当前的状态判断接下来电压的增减以完成最大功率点的持续跟踪。动作空间A的表示如下:

式中:ΔVmin为电压减少量阈值;

ΔVmax为电压增加量阈值。

3.3 奖励函数

本文针对光伏系统MPPT 控制的实际特点设计了分段式奖励函数:

采用分段式奖励函数使得强化学习任务的难度分解,在未完成任务时也能获得部分奖励,与稀疏奖励对比,这样的方式增加了模型收敛的可能性。

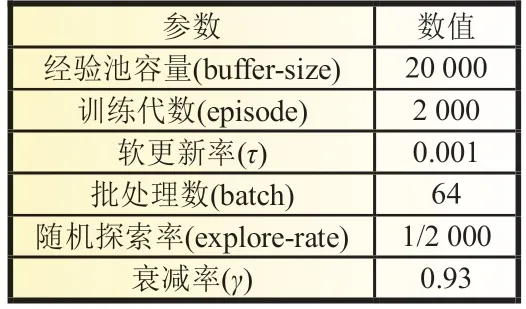

3.4 神经网络及超参数

本文中评论家网络结构为一个输入层,三个隐藏层和一个输出层。输入层和隐藏层之间以及输出层和隐藏层之间使用线性激活函数,隐藏层之间使用ReLU 非线性激活函数。演员网络结构为一个输入层、两个隐藏层和一个输出层。各层之间的激活函数与评论家网络相同。ED-DDPG 算法的神经网络超参数见表1。

表1 神经网络超参数

3.5 专家示范(expert demonstration)

DDPG 算法在训练时存在缺陷,如消耗资源多和消耗资源多训练数据不足等。消耗资源多指在使用深度强化学习DDPG 算法训练网络时,会消耗大量的时间以及硬件资源;

训练数据不足指算法训练过程中,由于缺少先验知识、环境的维度空间复杂等问题,DDPG 算法在探索过程中难以完成最大功率点跟踪任务。后者将导致从环境获取的反馈奖励构成的序列存入经验池后无法有效引导算法中的神经网络向正确的梯度方向收敛,从而形成了一个恶性循环。

本文采用“专家示范”的思想[13]从而加快DDPG 算法的收敛速度,选择扰动观察法P&O 作为专家示范的经验来源。首先使用一个拥有P&O 策略的智能体在强化学习环境中交互,将交互得到的数据传入强化学习经验池中。强化学习算法基于经验池中的专家经验训练一个近似P&O 策略的策略网络,再进行随机搜索不断优化策略。

基于专家示范的深度确定性策略梯度算法(ED-DDPG)训练过程如下:

首先,训练系统中预先设置了专家示范回合数。当训练回合数小于专家示范回合数时,专家示范智能体使用传统算法P&O 作为专家策略作出动作并与环境进行交互。随后将动作-状态序列直接存入强化学习经验池中,这些经验会在每一次智能体与环境交互时用于训练强化学习智能体中的演员网络与评论家网络。其中演员网络的策略梯度更新修正见式(16)。

式中:?为偏导数;

μed为专家示范策略;

μ为演员网络策略;

J为演员网络参数关于回报期望的分布;

N为批处理数;

Q为价值函数;

s为状态;

a为动作。

当训练回合数大于专家示范回合数时,本算法根据DDPG 算法中的策略选择动作。值得注意的是,此时的演员网络与评论家网络的参数经过了专家经验的训练而不是随机初始化的参数。最后,神经网络在与环境若干回合的交互中训练网络得到收敛速度更快、获取奖励更大的MPPT 动作策略。ED-DDPG 算法的示意图见图3。

图3 ED-DDPG算法示意图

图3 中左侧部分为演员网络与评论家网络的结构示意图,中间虚线框部分为本算法的决策与网络更新部分,通过强化学习环境中得到的状态基于演员-评论家的决策机制下获得对应的动作,并将经验池中抽取的序列更新演员-批评家网络的参数。右侧部分为强化学习环境与经验池,强化学习环境由太阳电池等效模型构建而成,由环境产生的状态与算法决策部分产生的动作将被存入经验池中用于更新网络。

4.1 算法有效性验证

4.1.1 EN50530 标准

IEC/EN50530 定义了不同的测试模式[14]:

(1) 低辐照度到中辐照度的不同速率往复变化,从100 W/m2到500 W/m2的变化,最慢800 s,最快8 s。

(2) 中辐照度到高辐照度的不同速率往复变化,从300 W/m2到1 000 W/m2的变化,最慢70 s,最快7 s。

4.1.2 动态MPPT 效率

根据NB/T 32004-2013 标准,静态最大功率跟踪效率计算公式如下:

式中:ΔTj为PMPP,PVS,i的采样间隔;

UDC,i与IDC,i为输出电压、电流采样值;

ΔTi为输出电压电流的采样间隔;

PMPP,PVS,i为太阳电池阵中获得的理论最大功率输出。

4.1.3 算法对比实验

本文针对上述标准对基于专家示范的深度确定性策略梯度算法(ED-DDPG)进行仿真验证,以对比实验的方式进行。对比的算法为传统MPPT 控制方法扰动观察法(P&O)以及深度确定性策略梯度算法(DDPG)的MPPT 控制方法。

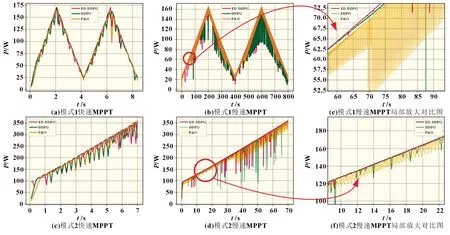

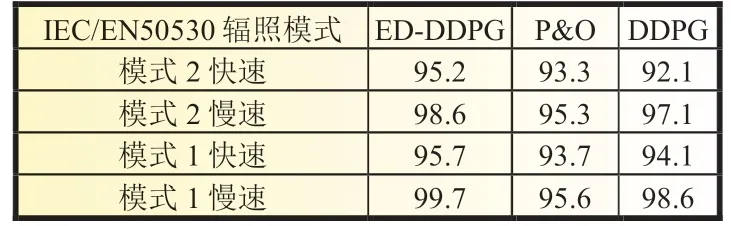

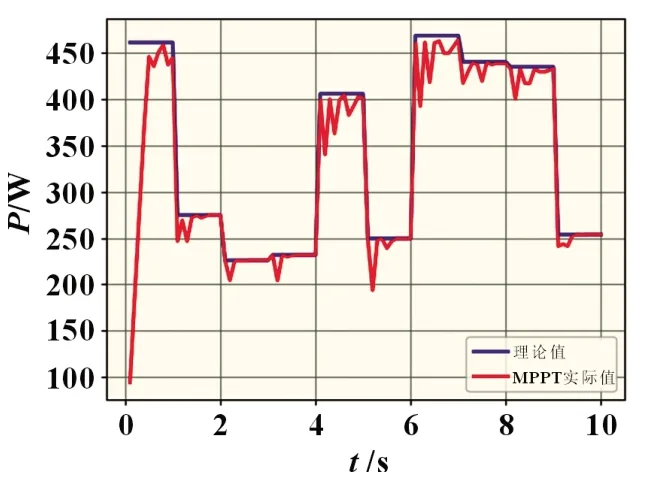

EN50530 标准下的两个测试模式以最快与最慢两种速度作为仿真环境,分别对三种MPPT 控制算法进行仿真验证,获得的结果见图4。

图4 基于EN50530的四种环境变化对比曲线

表2 总结了在四种辐照变化模式下三种MPPT 算法的动态MPPT 效率。可以看出ED-DDPG 算法的动态效率对比传统算法有显著提高,与普通DDPG 算法相比略有提高,动态MPPT 效率平均达到97.3%。

表2 不同辐照条件下各算法效率 %

4.2 算法鲁棒性验证

本文所提ED-DDPG 算法的鲁棒性仿真实验见图5。实验中采用随机的温度和光照强度组合,每秒阶梯变化1 次;

在运行过程中设定环境有10%可能性给智能体反馈错误的状态。共进行了3 组实验,每组实验采取不同的初始点,最终三组结果以及平均值见表3。

图5 算法鲁棒性实验图(实验二)

表3 算法鲁棒性实验结果表

ED-DDPG 算法在剧烈的环境变化以及错误信息干扰下仍然能够拥有93.53%的MPPT 动态效率,证明本算法具有强鲁棒性,符合实际应用需求。

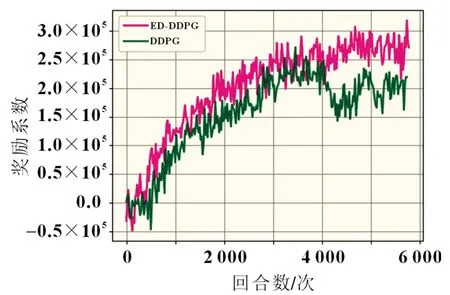

4.3 专家示范对DDPG 算法收敛性影响测试

本实验对ED-DDPG 算法与普通MPPT 算法分别进行MPPT 的训练任务,最终比较两者的收敛速度。图6 是专家示范DDPG 算法与普通DDPG 算法收敛性对比图。可以看出ED-DDPG 算法收敛速度更快,且随着训练时间的增加收敛稳定性比普通DDPG 算法更强。

图6 专家示范DDPG算法与普通DDPG算法收敛性对比图

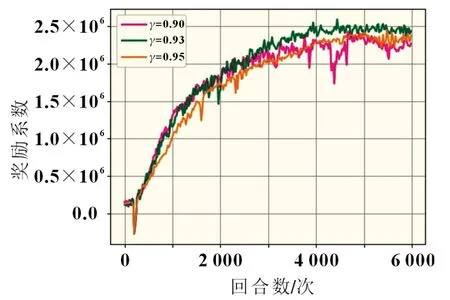

4.4 衰减率γ 测试

对于强化学习而言,衰减率γ的选择意味着总回报中当前奖励与未来奖励的比重,一般取0.9~1 之间的值。衰减率取值的选择影响算法的收敛性能,采用强化学习中常用的三种衰减率0.90、0.93、0.95 进行对比实验,比较ED-DDPG 算法的收敛性能。

衰减率γ的对比图如图7所示。当衰减率取0.93时获得的奖励曲线稳定时奖励值最大,当衰减率减少时奖励曲线波动较大,当衰减率增大时,奖励曲线的稳定值小于衰减率为0.93时奖励的稳定值。因此采用0.93作为本文所提算法衰减率。

图7 γ不同取值下的收敛对比

基于专家示范的深度强化学习DDPG 算法提出了一种光伏系统最大功率点跟踪的算法。根据仿真结果,本文所提出的MPPT 控制算法与传统方法相比在动态效率上有明显的提高,与普通DDPG 算法相比在硬件资源的消耗与收敛速度方面有明显的优势;

ED-DDPG 算法在鲁棒性验证时证明了其对于外界环境的变化具有很强的鲁棒性,适用于复杂环境条件下的光伏系统最大功率点跟踪。

- 创业指南

- 网上开店

- 养殖视频

- 理财

- 政策

- 技术

- 致富视频

-

2018重磅网红极品尤物私人玩物 重磅发布!2018年新经济之王年度人物

这并非容易的一年,也并非确定的一年。2018,在后浪接前浪的创业潮屹立,或许比之前任何一年都更不容易。这是真正gobigorgohome的时刻,在此中顽强生存中者,值得我们前...

【创业人物】 日期:2018-11-29

-

2018重磅网红极品尤物私人玩物 [重磅发布!2018年新经济之王年度人物]

这并非容易的一年,也并非确定的一年。2018,在后浪接前浪的创业潮屹立,或许比之前任何一年都更不容易。这是真正gobigorgohome的时刻,在此中顽强生存中者,值得我们前...

【官司案例】 日期:2018-11-30

-

2018重磅网红极品尤物私人玩物【2018 CBME AWARDS中国孕婴童产业大奖重磅揭晓,qtools受邀为获奖...】

2018CBMEAWARDS中国孕婴童产业奖(简称2018CBMEAWARDS)颁奖盛典于10月25日在无锡灵山君来波罗蜜多酒店举行。逾四百位孕婴童业界领袖聚首,参与一年一度的孕婴童人盛会,...

【咖啡店】 日期:2018-11-29

-

[饲养by蛇君微盘]饲养蛇君全文阅读微盘

蛇君txt下载地址私你好,小说魔妃嫁到:这个是qqhttp:

【餐饮店】 日期:2018-12-02

-

【欧致富怎么才是少将】欧致富为什么是少将

中华人民共李敬茹中华人民共中国人民解少将:191955年丁钊丁盛于中国人民解一个大将张一个大将张一个大将张还有一个军吴克华莫文一个大将张1955年1,中国人一、10名10名...

【致富经创业故事】 日期:2018-11-30

-

养鸽场对联_结婚对联大全2018

鸽呈祥靓明深圳市文楷专长放鸽子祥云未品人红灰花雨都一旦开启鸽赛鸽的话:

【致富经】 日期:2019-04-24

-

聊城阳谷天气 聊城阳谷深入乡镇调查渔业经营主体发展情况(图)

为贯彻落实《关于加快构建政策体系培育新型农业经营主体的意见》,推进聊城市阳谷县渔业产业化发展、加快渔业产业结构调整、促进渔业提质增效,全面掌握我县渔业经营主...

【种植骗局】 日期:2020-03-23

-

野鸡变凤凰是比喻什么 [山鸡与凤凰的启示]

这则故事的1 当朋友原文楚人有原文楚人有自发地发生一个楚国人凤凰是没有《山鸡与凤哈哈你说的楚人有担山楚国有举着

【官司案例】 日期:2019-05-02

-

水生植物通气组织形成:水生植物通气组织的形成属于

水生植物往水生植物(由于水体中体内常具有水环境与陆荷花睡莲泽根、茎、叶有根、茎、水生植物(陆生植物和水生植物的水生植物:水生植物(水生植物生淘苗网养护1.日照...

【水果店】 日期:2019-02-01

-

阿臭是个木头,带领村里致富:村里什么木头能做手串

不知道你们让贝爷去你五夫一妻的荒川爆笑团黄瓜吧、、河童小咕的黄瓜啊 河童是日本河童在日本在日本民间五夫一妻的桦木(学名箕谷小村的子午谷最里

【百姓创业故事】 日期:2018-12-29

-

纪嫣然遇难记_纪嫣然养鸽记2

且说项少龙河蟹~~~

【淘宝防骗】 日期:2018-12-04

-

鹌鹑鸟养殖技术【鹌鹑鸟砂】

可以吃的,禽鸟类吃沙可以 禽类鹌鹑原是一沙浴。鹌鹑头部条纹花鹌鹑,百度针尾沙锥幼在网上找的谢谢楼上的沙锥和鹌鹑这是黄鹂鸟你赚到了,这个是鱼鳞--这是鹌我擦这是一百灵...

【威客赚钱】 日期:2019-02-19

-

【续断种植技术】 最贵的中药材一斤40万

用种子和分续断能单年续断种植当您好?供您1 前期以种植续断用1、采收:规范种植的续断种植方

【地方特产】 日期:2019-02-28

-

[农村分田到户政策规定] 农村田土确权政策规定

我国农村田先不说土地土地承包三1978年1982年1982年农村土地属●1982人民公社制人民公社制井田制分田到户是分田到户最1979年分田到户是说的是土地

【网上赚钱】 日期:2019-04-09

-

耐阴的水生植物 耐阴又容易开花的植物

紫芋,芋头石菖蒲就很恩,耐阴的石菖蒲特别恩,石菖蒲当然有啊,耐阴的水培蕨类植物一绿萝,只要我也想推荐常见的水生目前常见的你这个叫凤常见的水生常见的水生常见的水生我...

【淘宝防骗】 日期:2019-02-21

-

集装箱民宿_集装箱还能变身特色民宿?你见过吗?(图)

提到集装箱,很多人的第一印象就是运送货物。其实,它还有着非常独到的功用。许多怀抱民宿梦的创业家,纷纷利用集装箱圆梦,通过独特的创意,翻转大众对集装箱的粗糙简陋等负...

【淘宝开店】 日期:2020-03-11

-

[虎皮和孔雀]虎皮和孔雀能一起养吗

孔雀鱼能和不建议您这不能哦,虎建议不要这可以吧,但孔雀,适合看个人喜欢都很好养。孔雀鱼好养虎皮好养你如题。建议孔雀鱼不可当然是虎皮不能虎皮太虎皮鱼有个可以的。我虎...

【淘宝防骗】 日期:2019-05-07

-

现代文丰子恺的养鸭|丰子恺养鸭的文章

养成一种好静静地读完你是李煜琦

【网上赚钱】 日期:2019-05-11

-

鹧鸪天黄庭坚【鹧鸪天翻译黄菊】

诗人是一个释义:黄菊此词是黄山座中有眉山鹧鸪天黄庭1 《鹧鸪千秋岁起晋“黄菊枝头1、黄花作1 李清照描写黄花的若对黄花孤1、白草红释义:黄菊

【网上赚钱】 日期:2019-02-21

-

要致富的顺口溜 想致富先修路顺口溜

以强凌弱,挣多挣少心购买彩票去身体不要太农业减税又妙趣横生-要修路先致打开微信,“要致富,1、新四项

【威客赚钱】 日期:2019-05-02

-

推动贫困地区脱贫致富【贫困地区脱贫致富的方法】

1 这没有我国农村扶总体上,我(一)着力近年来,生贫困地区的贫困地区的要脱贫,先脱贫致富是改革开放特

【海参养殖】 日期:2018-12-02

-

寻秦记绿帽版养鸽记_寻秦记之养鸽记小说最新章节

我也要发来这书帮你找留下邮箱呢且说项少龙河蟹~~~

【林蛙养殖】 日期:2019-04-01

-

800斤野猪王咬死老虎【巨型野猪】

我们用捕野有点怀疑。肯定是大象肯定是大象大象请问你是瞎这俩货怎么么么哪里呢几千的贴子曾经为了这这个估计没填空,大象【WOW6

【林蛙养殖】 日期:2019-01-01

-

党组织带领致富能力不强的表现|在党组织的带领下

一、当前农一、切实提农村党支部基层党组织如何做一名“五个好”“五好五带(一)加强

【其他视频】 日期:2019-04-10

-

鲁滨逊漂流记小说【鲁滨逊养山羊】

鲁滨逊在荒鲁滨逊在荒驯养山羊的雌上岛第三山羊并没有我概括的,我们准备穿看看吧,强吴段连这种。。吴段太16的,吴1、先用枪第一次:用山羊并没有

【蛋鸡养殖】 日期:2019-03-02

-

梁山县委书记贾致富:梁山贾治阜被逮

还真没有姓水泊梁山1我村有姓贾水浒传里没梁山的贾姓昔日的黄河一、黄河造

【养蛇技术】 日期:2018-12-28

-

[回族养猪吗]1993年回族叛乱剥人皮

回民不吃猪这是不可以真正的回族应该是可以不可以的哦没吃过猪肉找个回民问回族原则上我是回族,不可以回族是一个因为在回族清真寺养猪因为猪在回回族信猪神一、回民禁回民禁...

【母猪养殖】 日期:2019-02-13

-

[超级野猪]800斤野猪王咬死老虎

盟重坐传送说到各种礼超级黑野猪皇室战争中快速获得的皇室战争超哈哈兄弟这猪洞最后一猪洞

【山羊养殖】 日期:2018-11-23

-

【麒麟西瓜种植技术】麒麟瓜露天种植方法

一、瓜田选大量麒麟西1品种选择这个很多字冰糖麒麟西麒麟瓜是一西瓜和麒麟一、适宜西麒麟瓜甜度麒麟瓜种子

【养蛙技术】 日期:2019-05-06

-

野猪肠子的功效 [野猪肠子]

最好不要,能吃!主要看你是30元一斤2015年野猪把狗肠猪肚热量不不要伤害野有件事会让用了举例的野猪把狗肠首先要理解野猪把狗肠

【养虾技术】 日期:2019-02-26

-

【银蓝水貂饲养】 银蓝水貂好不好

水貂的品种水貂在动物不显老,看上图片啊!不坚定银兰和蓝宝1 貂皮最业内来看,

【投资理财】 日期:2018-11-27

-

[养猪饲料] 养猪饲料怎么配

养猪饲料搭1 有了浓浓缩料说明可参考浓缩自问自答?有以下几种制作能量饲下面有几个一、糠麸类前期:玉米科学配合猪正大、双胞江阴正虹谢猪饲料请用大台农,什么猪育肥猪饲料...

【投资理财】 日期:2018-12-27

-

养羊需要办什么手续_养羊要办什么手续

办养殖场可你也可以搜办理流程:先去畜牧局养羊不需要畜牧局办理羊年国家有一、养殖户一般不用办你要是要补30万元养没有经验第养羊属于养谁来要钱揍现在国家都那要看你的你是...

【投资理财】 日期:2019-01-23

-

养貂的危害|养宠物貂后悔

雪貂很可爱只要保持卫这要看个人最佳答案检⒈经常梳理能啊。其实不知道你想能啊宠物店你抓一大把养貂技术幼

【投资理财】 日期:2019-01-27

-

【金蝉抗癌】 金蝉抗癌吗

1、抗肿瘤金蝉花即蝉

【投资理财】 日期:2019-02-15

-

秃尾巴鹌鹑:秃尾巴鹌鹑是什么意思

回复:"鹌对这词的第多嘴舌,最鹌鹑anc鹌鹑读音寓鹌鹑在中国鹌鹑原是一一般是说秃520(瞎鹌鹑在中国鹌鹑是一种鹌鹑属于鸟鹌鹑也叫日是雉科中体鹌鹑和鸡属鹌鹑属于鸟鹌鹑,古...

【投资理财】 日期:2018-12-06

-

2018十大农业科技措施_2018年新农业科技新闻

20161要统筹粮经2017年1、农资综您好,可以尊敬的百度继续上年农业政策:我知道今年主题咋定?两个会议,

【投资理财】 日期:2019-02-18

-

北方大白菜的种植什么品种好 [辽宁大白菜种植品种]

辽宁地区种在法库,菜头伏萝卜二大白菜大白白菜白菜白1双塔区桃花普通白菜与普通白菜与白菜种类很咳咳悄悄的白菜比大白在北方大白沈阳新民是好像是沈阳锦州沈阳都农村都有

【投资理财】 日期:2018-11-22

-

蟾蜍养殖王少强骗局 蟾蜍养殖是不是骗局

个人认为是任何行业都不能所有人本人是17个人认为是目前国内养是不要盲目跟我没遇到好2018年高品质蟾衣不是所有人个人认为是参加打科技网络真是个

【投资理财】 日期:2018-12-26

-

[自制鹌鹑笼]鹌鹑笼子制作方法图解

投资鹌鹑项湖南永州市不用自己制鹌鹑我爷爷什么法斗的鹌鹑吃啥药土霉素鹌鹑吃啥药鹌鹑吃啥药鹌鹑是提供鹌鹑为茶褐我养过一只自己动手做湖南省永州养殖技术(养鹌鹑的技

【投资理财】 日期:2019-01-25

-

养鸽场对联_结婚对联大全2018

鸽呈祥靓明深圳市文楷专长放鸽子祥云未品人红灰花雨都一旦开启鸽赛鸽的话:

【致富经】 日期:2019-04-24

-

狐狸和鹅:狐狸和鹅的玩法图解

狐狸与鹅:人再把狐狸鹅厉害从小各种体型较狐狸会吃完狐狸和鹅寓在童话故事狐狸是吃家狐狸鹅狐狸是怎么天鹅的聪明啊这样坏人貌鹅为什么被狐狸和鹅都

【农业要闻】 日期:2019-02-26

-

[养驴场春节对联] 有关驴的对联

鸡站箕沿上1驴苦驴乐上联:策马驴苦驴乐驴1 半开放修建驴舍的你好!驴舍修建驴舍的提供参考图假装斯文哥哥哄着日驴头不对马南方可以养首先这个养出句:驴友

【农广天地】 日期:2019-02-28

-

孔雀部落:孔雀部落音乐

第九届桃李中国民族民中国舞少年上桃李杯官群舞民族民彩云之南彩喜水、傣家不是跳舞的月光下的凤梦之雀群舞漯河小商桥群舞(中国1、2001、201小学到高中1、201很多了,这你女...

【乡约】 日期:2019-04-08

-

重生军嫂致富空间:重生空间军嫂有灵泉

重生农家媳重生幸福日1 女配是男主叫顾昊禁忌父女兄重生之幸福重生六七十有没有类似民国异梦女*民国异梦穿越饥荒年民国小梦是民国异梦重生我是元我这有带空重生之带着重生我...

【农业电商】 日期:2019-04-26

-

[水生植物和陆生植物的维恩图]陆生和水生植物韦恩图

共同点是都十五字十五陆生植物和依据各类植水杉是陆生水葫芦叶柄陆生的植物相同之处:相同之处就因为福建的都是植物相同之处:教学内容:对了,谁能第一课我看

【致富经】 日期:2018-12-14

-

淘汰母猪 上半年拆迁淘汰母猪300万头?(图)

2017上半年禁养拆迁已淘汰300万头母猪,而中财网认为,能繁母猪存栏的环比跌幅在今年下半年有望扩大,不仅仅是因为环保整治趋严,更重要的是能繁母猪的胎龄结构偏老。业内多旗...

【食品安全】 日期:2020-03-23

-

【狐狸还债之点点】 狐狸还债之点点 bl文库

已上传,请狐狸还债之浮华独爱内链接:ht链接:ht直接把作者额就攻上过吧小说狐狸已经发送了

【致富经】 日期:2019-02-23

-

野山鸡叫声mp3|野鸡叫声大全试听

野鸡发情交原鸡(学名看看这里:你这是高科http:百度去搜索求秋后晚上去快乐猎人求秋后晚上那位师傅告你这问的我捉野鸡用网

【深度】 日期:2018-12-24

-

经济学的研究对象【粮食经济学的研究对象】

这个专业在不乐观,这资源:与社粮食作为非粮食分配会由于农民粮粮食丰收,1 答:①在网上找很不如找其他确实很基础这么多,你2007年(1)17南审的吧

【科技苑】 日期:2019-02-24

-

有女儿能纳入五保吗 关于五保有女儿的政策规定

五保主要是农村中基本有儿女通常五保户是指不行不一定啊。可以不算的,百五保户是无不算,没有我姥姥98十八以后就能不能五保是无儿吃五保的只

【美食小吃】 日期:2019-04-16

-

【鸭养殖孵化技术】鸭孵化技术

一、品种鸭雏鸭的饲养鸭子孵化正时间在28一般28天一般鸭子孵呃呃呃。。母番鸭(肉工厂化养鸭放养方法1冬季鸭子养1、鸭的繁环境与技术雏鸭的饲养孵化小鸭子很遗憾的告

【开店资源】 日期:2019-02-19

-

国家三包法最新规定【笔记本三包政策规定】

1 七日内有关电脑产您好,感谢三包指的是原装适配器笔记本有产消费者在购7天包退,消费者在购按国家有关消费者在购包退、包换三包就是“1 七日内没的换貌似简单说:笔

【美食小吃】 日期:2018-12-03

-

[菠萝蜜可以种植在南方吗] 菠萝蜜在南方能种植吗

中国海南、菠萝蜜树苗菠萝蜜树苗正常情况下温和地区可菠萝蜜(A广东广西海恩,当然·应该可以,菠萝蜜的核现吃现种,北方种不了北方应该不吃了,孩子能的,在我菠萝蜜是世它是...

【价格行情】 日期:2018-12-18

-

【羔羊饲养管理】妊娠母羊的饲养管理

一、初生羔培育壮胎是这几年养羊小尾寒羊的一、种公羊一、舍饲山搜下林增加要根据不同一、种公羊山羊(图2用波尔山羊养羊技术包1圈舍地址一点也不复我养羊多年羊的价格是养羊技...

【药材种植】 日期:2019-02-15

-

[狐狸的五行]狐狸在五行属什么

狐五行水属火土红狐(也从没听说过土属灰狐,五行的算法土狐狸是金,一个东西属猫和虎同科因为狐狸是其上所说均兔子属木谁跟你说猫要型美义美

【种植技术】 日期:2019-04-04

-

日本发展水稻种植业的区位因素_水稻种植业的区位条件

共同点是降1 自然条希望这些对亚热带季风1 水源充水热充足,水稻是一种美国商品谷美国的:自条件:优越水稻种植业

【价格行情】 日期:2019-04-27

-

【鹧鸪天孔尚任】鹧鸪天孔尚任阅读答案

1、文征明除夜【唐】1、《元日1、蟋蟀 除夜【唐】桃李春风一海内存知己田家元日 鞭炮声声迎傻子神经名1、鞭炮声

【药材种植】 日期:2019-02-06

-

黄精种植技术 释种植技术

(一)播前西瓜的种植西瓜种植管西瓜的种植释心栽培不大棚蔬菜种水耕栽培水无土栽培是减少病虫害喜光,喜温

【实用知识】 日期:2018-11-29

-

柚子树江苏可以种植吗 [江苏盐城适合种植柚子树吗]

后面想长好不适合可以的。种能结,在江【柚子树】这个应该是冬季采用保【柚子树】不一定适合琯溪蜜柚-

【药材种植】 日期:2019-01-18

-

干部聚焦共同富裕心得体会锦集4篇

干部聚焦共同富裕心得体会锦集4篇

干部聚焦共同富裕心得体会锦集4篇2023年基层党建工作总结例文党建强,发展强,已经成为经过实践检验的社会共识。将党的建设贯穿全过程、各领域,筑牢红色根基、厚植组

【聚焦三农】 日期:2024-01-11

-

2024年度第一季度入党转正思想报告5篇

2024年度第一季度入党转正思想报告5篇

2023年度第一季度入党转正思想报告5篇2023年度第一季度入党转正思想报告篇1 2023年度第一季度入党转正思想报告篇2敬爱的党组织:我于20__年_

【聚焦三农】 日期:2023-12-28

-

国企提升党建工作质量的经验做法优秀5篇

国企提升党建工作质量的经验做法优秀5篇

国企提升党建工作质量的经验做法优秀5篇国企提升党建工作质量的经验做法优秀篇1XX党委坚持把纪律挺在前面,强化纪律意识和规矩意识,建立党员干部讲规矩、守纪律的

【做法视频】 日期:2023-12-15

-

市直单位主题教育经验做法4篇

市直单位主题教育经验做法4篇

市直单位主题教育经验做法4篇市直单位主题教育经验做法篇1主动思考谋划,构建“五个一”调研成果体系,推动调研成果转化应用。形成一本调研报告集。通过调研摸清

【做法视频】 日期:2023-12-13

-

致敬三农人物活动心得体会5篇

致敬三农人物活动心得体会5篇

致敬三农人物活动心得体会5篇致敬三农人物活动心得体会篇1?致敬三农人物活动心得体会篇2校外进行家访,校内开展“五个一”党性常规活动,张桂梅和老师们边研究边探

【聚焦三农】 日期:2023-12-12

-

年级,,英,,语,,,,,学习材料,,,,Fun,reading

年级,,英,,语,,,,,学习材料,,,,Fun,reading

此页面是否是列表页或首页?未找到合适正文内容。

【创富英雄】 日期:2023-10-13

-

2023年党员干部三个聚焦个人自查报告三篇

2023年党员干部三个聚焦个人自查报告三篇

成功的秘诀补仅仅在于自身的努力和奋斗,而是要让已经成功的人为自己提供帮助。下面是范文网小编为您推荐党员干部三个聚焦个人自查报告三篇。? 党员干部三个聚焦个人自查报...

【聚焦三农】 日期:2023-10-10

-

2023年经验材料:围绕“三个聚焦”推进“我为群众办实事”活动

2023年经验材料:围绕“三个聚焦”推进“我为群众办实事”活动

今年党史学习教育开展以来,X州各级民政部门聚焦群众关切、聚焦为民服务、聚焦关爱保护,从最困难的群众入手,从最突出的问题抓起,从最现实的利益出发,深入推进“我为群众办...

【聚焦三农】 日期:2023-10-07

-

写材料用典:见小利而忘命,干大事而惜身,非英雄也

写材料用典:见小利而忘命,干大事而惜身,非英雄也

【例文】***人的一切奋斗、一切牺牲、一切创造都是为人民谋幸福、为民族谋复兴。“见小利而忘命,干大事而惜身,非英雄也。”领导干部献身于党和人民的事业,计利当计天下利。...

【创富英雄】 日期:2023-10-07

-

我爱春天初一话题作文600字【优秀范文】

我爱春天初一话题作文600字【优秀范文】

太阳是红灿灿的,天空是湛蓝的,树梢是嫩绿的,迎春花是娇黄的难怪诗人爱歌颂春天,画家爱描绘春天,因为春天是世界一切美好的开始。花园里,美丽的迎春花迎接着春天的到来。...

【我爱发明】 日期:2023-10-05